Rcemment grâce à twitter, j'ai pu découvrir certains projets sur GitHub, sur l'intelligence artificielle et j'ai pu lire quelques recherches faites en Asie et ailleurs, qui projettent des approches mathématiques avancées :

👉🏻 AceMath : https://arxiv.org/abs/2412.15084

👉🏻 rStar-Math https://arxiv.org/pdf/2501.04519

👉🏻PRIME https://arxiv.org/abs/2412.01981

Bien que ces recherches présentent des idées différentes, un fil conducteur émerge : l'importance d'un prompt de haute qualité et difficile, avec une réponse vérifiable, loin de mon précédent article sur Mistral AI qui flippe sur le nombre de répétitions de lettre "t" dans le mot "Tartiflette".

Voici ce qu'on peut retenir :

1. AceMath propose une approche simple, le "rejection-fine-tuning" (RFT), pour étendre l’ensemble des données SFT à une échelle massive, en se basant sur la correspondance de réponses vérifiables. Aucun RM n’est nécessaire, mais il peut tout de même être utilisé pour améliorer les performances.

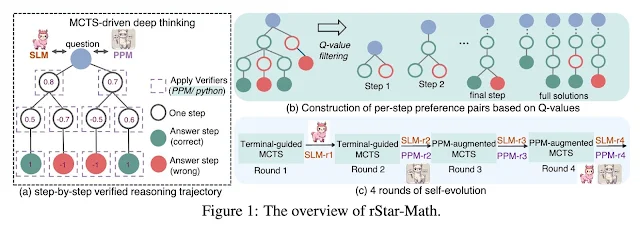

2. rStarMath utilise une approche SFT auto-évolutive pour améliorer progressivement la qualité des données et la performance du modèle de préférence de processus (PPM). Il reste un RFT, où les échantillons proviennent de MCTS guidé par le PPM. Cependant, une supervision forte est requise avec des récompenses vérifiables à la fin. rStarMath optimise également le calcul d'inférence en utilisant le PPM à chaque étape.

3. PRIME adopte un angle différent. Il utilise PPO pour entraîner le modèle, mais sa principale contribution réside dans l'attribution de récompenses pour les résultats à chaque étape intermédiaire. Il repose fortement sur l’utilisation de réponses vérifiables pour obtenir des sorties « correctes » du modèle en politique.

Tous ces travaux tendent à des résultats similaires. #Eurus2 semble un peu plus faible en raison de la taille de son ensemble d’entraînement plus petit. Cependant, ces résultats sont déjà proches de o1-mini d' @openaiai. En tenant compte des fuites concernant la taille de o1-mini (~20B), on peut dire qu'il n'y a pas de véritable écart avec o1, du moins pour les problèmes mathématiques. Cela étant dit, o1-mini pourrait l'emporter sur des tâches de raisonnement plus larges comme la physique, les casse-têtes, etc.

On comprend bien que pour atteindre le o1, ce n'est peut-être pas tant un problème d'algorithmes que de données ou d'infrastructure. En trouvant des moyens efficaces de scaler des paires de bons prompts difficiles et réponses vérifiables provenant de différents domaines, l’algorithme en lui-même semble avoir une influence moindre.

Par Aghilas AZZOUG